| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- 서평단

- 딥러닝

- 독후감

- Ga

- Google Analytics

- tensorflow

- Blog

- Pandas

- 한빛미디어서평단

- 텐서플로

- 서평

- 한빛미디어

- MATLAB

- Linux

- 통계학

- 블로그

- matplotlib

- 리눅스

- Python

- Tistory

- MySQL

- 매틀랩

- python visualization

- 티스토리

- 시각화

- SQL

- 월간결산

- Visualization

- 파이썬 시각화

- 파이썬

- Today

- Total

목록빅데이터/빅데이터기술 (13)

pbj0812의 코딩 일기

[빅데이터기술] DBT 설치 및 MySQL 에 연결 해보기

[빅데이터기술] DBT 설치 및 MySQL 에 연결 해보기

0. 실습 1) 설치 - MySQL 기반으로... pip3 install dbt pip3 install dbt-mysql 2) 프로젝트 시작 - 아래 작업을 해야 profiles.yml 파일이 생성됨. dbt init my_project - 동시에 폴더들도 생성됨 3) yml 파일 수정 vi ~/.dbt/profiles.yml my_project: target: dev outputs: dev: type: mysql server: 127.0.0.1 port: 3306 database: sql_study # optional, should be same as schema schema: dbt_test username: root password: driver: MySQL ODBC 8.0 ANSI Driver p..

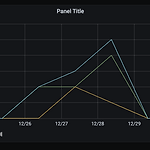

[빅데이터기술] Grafana + ElasticSearch 시계열 대쉬보드 생성

[빅데이터기술] Grafana + ElasticSearch 시계열 대쉬보드 생성

0. 목표 - Grafana + ElasticSearch 시계열 대쉬보드 생성 1. 실습 1) ElasticSearch 설치(링크) 및 데이터 생성(링크) 2) Grafana 설치 및 실행(링크) 3) Configuration -> Data Sources 4) Add data source -> Elasticsearch 5) 연결 - save and test 로 연결 확인 - ES 버전이 중요 - Time field 설정 6) Create -> Dashboard 7) Add new panel 8) 쿼리를 세개 만들어서 소년의 결과와 소녀의 결과와 전체의 결과를 시각화 9) 완성 - 9:00 기준으로 묶이는건 왜인가...

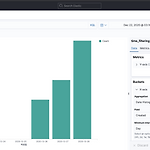

[빅데이터기술] Kibana에서 날짜를 기준으로 한 바 차트 생성

[빅데이터기술] Kibana에서 날짜를 기준으로 한 바 차트 생성

0. 목표 - Kibana에서 날짜를 기준으로 한 바 차트 생성 1. 데이터 삽입 1) library 호출 from elasticsearch import Elasticsearch from elasticsearch import helpers 2) ES 연결 es = Elasticsearch('http://127.0.0.1:9200') es.info() 3) 인덱스 생성 함수 def make_index(es, index_name): if es.indices.exists(index=index_name): es.indices.delete(index=index_name) es.indices.create(index=index_name) 4) 날짜 생성 - ES에서 인덱스 생성시 자동으로 날짜 포맷으로 인식하기 위해..

[빅데이터기술] ElasticSearch, Kibana에서 원하는 단어만 필터링하기

[빅데이터기술] ElasticSearch, Kibana에서 원하는 단어만 필터링하기

0. 목표 - ElasticSearch, Kibana에서 원하는 단어만 필터링하기 - ES, Kinbana 설치 및 실행 1. 데이터 생성 1) library 호출 from elasticsearch import Elasticsearch from elasticsearch import helpers 2) ES 연결 es = Elasticsearch('http://127.0.0.1:9200') es.info() 3) 인덱스 생성 함수 def make_index(es, index_name): if es.indices.exists(index=index_name): es.indices.delete(index=index_name) es.indices.create(index=index_name) 4) 테스트 데이터 i..

[빅데이터기술] docker 로 ElasticSearch + Kibana 연동 + python 연동을 통한 데이터 삽입 및 확인

[빅데이터기술] docker 로 ElasticSearch + Kibana 연동 + python 연동을 통한 데이터 삽입 및 확인

0. 목표 - docker 로 ElasticSearch + Kibana 연동 1. 도커 설정 1) elasticsearch docker 이미지 가져오기 docker pull docker.elastic.co/elasticsearch/elasticsearch:7.10.1 2) 컨테이너 실행 - 9200 포트 연결 docker run -d -p 9200:9200 -p 9300:9300 -e "discovery.type=single-node" docker.elastic.co/elasticsearch/elasticsearch:7.10.1 3) 실행 컨테이너 확인 docker ps 4) localhost:9200 5) kibana docker 이미지 가져오기 docker pull docker.elastic.co/k..

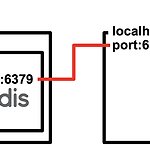

[빅데이터기술] Docker redis 컨테이너 생성 및 jupyter notebook 에서 실행

[빅데이터기술] Docker redis 컨테이너 생성 및 jupyter notebook 에서 실행

0. 목표 - Docker redis 설치 및 jupyter notebook 에서 설치 - 플로우 차트 1. 실습 1) redis (1) redis container 생성 - redis 이미지를 이용하여 컨테이너의 6379 포트를 외부(localhost)의 6379 포트와 연결 docker run -d -p 6379:6379 redis (2) container 실행 확인 docker ps 2) python (1) redis library 설치 pip install redis (2) library 호출 import redis (3) redis 연결 r = redis.Redis(host='localhost', port=6379, db=0) (4) 데이터 삽입 r.set('foo', 'bar') (5) 데이터..

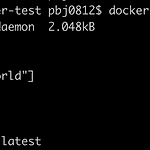

[빅데이터기술] Docker 이미지 파일 생성

[빅데이터기술] Docker 이미지 파일 생성

0. 목표 - Docker 이미지 파일 생성 1. 실습 1) Dockerfile 생성 - 파일명 Dockerfile - alpine 이미지 사용 - 결과 : hello world 출력 FROM alpine CMD ["echo", "hello world"] 2) 빌드 - 현재 폴더에서 Dockerfile 을 찾아 빌드하고 이름은 pbj0812/test 로 지정, latest 는 버전 docker build ./ -t pbj0812/test:latest 3) 생성 이미지 확인 - 두 개 있는 이유는 그냥 하나 더 만들은거... docker images 4) 컨테이너 실행 docker run -it pbj0812/test 2. 참고 - 따라하며 배우는 도커와 CI환경

[빅데이터] MacOS 에 hadoop 설치

[빅데이터] MacOS 에 hadoop 설치

* 단순 설치 및 명령어만 실험을 하였기에 제대로 된 설치법(sh 수정 등)은 다른 블로그를 참고 바랍니다. 0. 목표 - macOS에 hadoop 설치 1. 실습 1) hadoop 설치 brew install hadoop - 결과 - hadoop 위치 : /usr/local/Cellar/hadoop/3.3.0 2) 네임 노드 포맷 hdfs namenode -format - 결과 3) 대쉬보드 확인 - http://localhost:8088 - 노드 설정 등을 아무것도 하지 않은 상태 4) hadoop 명령어 테스트 - 명령어 참고 : blog.voidmainvoid.net/175 hdfs dfs -ls 2. 참고 - 맥(mac)에서 하둡(hadoop) 설치하기 - Hdfs dfs 명령어 정리 및 설명(..

[빅데이터기술] Mac OS에 PySpark 설치

[빅데이터기술] Mac OS에 PySpark 설치

0. 목표 - PySpark 설치 1. 설치 1) java 설치 확인 java -version - 결과 java version "12.0.2" 2019-07-16 Java(TM) SE Runtime Environment (build 12.0.2+10) Java HotSpot(TM) 64-Bit Server VM (build 12.0.2+10, mixed mode, sharing) * java가 설치되어 있지 않으면 설치 필요 (참고) 2) PySpark 설치 pip install pyspark 2. 확인 + 에러잡기 1) cmd 환경 (1) 창에 pyspark 입력 * 아래와 같은 문구가 포함된 에러가 발생하는 경우 Service 'sparkDriver' failed after 16 retries (on..

[빅데이터기술] QWIKLABS를 통한 BigQuery 실습

[빅데이터기술] QWIKLABS를 통한 BigQuery 실습

0. 목표 - Big Query 튜토리얼 1. 실습 1) 링크 접속 - Exploring Your Ecommerce Dataset with SQL in Google BigQuery 클릭 - 이후 좌측의 Start Lab 버튼 클릭 2) 실습환경 로그인 - Open Google Console 클릭 - id, pwd에 Open Google Console 아래에 있는 id, pwd 이용 3) 좌측 목록 중에서 BigQuery 클릭 4) BigQuery 환경 5) API 사용하기 - 링크에서 사용 클릭 - dataset을 사용하기 위해서 필요 6) dataset 부르기 - 링크를 클릭하면 생성(data-to-insights) 7) 데이터 확인 - data-to-insights -> ecommerce -> all..