| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- MySQL

- 티스토리

- MATLAB

- Google Analytics

- tensorflow

- Visualization

- 독후감

- 딥러닝

- Linux

- Tistory

- 리눅스

- 서평단

- Python

- 파이썬 시각화

- 서평

- SQL

- 텐서플로

- Ga

- 시각화

- python visualization

- Blog

- Pandas

- 월간결산

- 한빛미디어

- 파이썬

- 통계학

- 한빛미디어서평단

- matplotlib

- 블로그

- 매틀랩

- Today

- Total

목록빅데이터 (65)

pbj0812의 코딩 일기

[자동화] airflow 에 airflow-code-editor 설치

[자동화] airflow 에 airflow-code-editor 설치

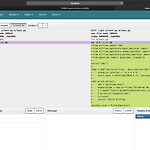

0. 목표 - airflow 에 airflow-code-editor plugin 설치 1. 설치 1) airflow 설치 pip install apache-airflow 2) airflow-code-editor 설치 pip install airflow-code-editor 3) 이외 라이브러리들 - 되는 버전을 알려주신 빅데이터 엔지니어 한용준 님께 감사의 인사를 드립니다. pip install marshmallow==2.19.5 pip install marshmallow-enum==1.5.1 pip install marshmallow-sqlalchemy==0.18.0 2. airflow 실행 1) 실행 airflow initdb airflow webserver -p 8080 2) 익스플로어에 local..

[AWS] AWS DynamoDB 테이블 생성 및 삭제

[AWS] AWS DynamoDB 테이블 생성 및 삭제

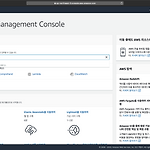

- 해당 튜토리얼은 AWS 에서 제공하는 튜토리얼을 참고하였습니다. 0. 목표 - AWS 의 DynamoDB 테이블 생성 및 삭제 1. 실습 - AWS console 에서 dynamodb 검색 2) 테이블 만들기 클릭 3) 테이블 설정 이후 하단의 생성 클릭 - 테이블 이름 작성 - 기본 키 작성 - 기본 설정 사용 체크 해제 4) 항목 만들기 클릭 5) 내용 작성 및 저장 6) 데이터 추가 결과 - 5번 넣음 7) 스캔 -> 쿼리 8) 검색 내용 작성 이후 검색 시작 클릭 9) 데이터 삭제 - 데이터 옆의 체크 박스 클릭 -> 작업 -> 삭제 10) 테이블 삭제 - 테이블 명 클릭 -> 테이블 삭제 클릭 2. 참고 - NoSQL 테이블 생성 및 쿼리

[AWS] Amazon Comprehend 를 이용한 감정분석

[AWS] Amazon Comprehend 를 이용한 감정분석

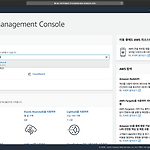

0. 목표 - Amazon Comprehend 를 이용한 감정분석 1. 실습 1) AWS Console 에서 Amazon Comprehend 검색 2) Launch Amazon Comprehend 클릭 3) 예제 문장 입력 및 Analyze 클릭 - 부정적인 글을 입력 4) Sentiment 클릭 - NEGATIVE 가 0.9 이상으로 나옴

[AWS] Lambda 를 통한 hellow, world 실행

[AWS] Lambda 를 통한 hellow, world 실행

- 공식 튜토리얼을 참조하시면 더욱 많은 예제를 보실 수 있습니다. 0. 목표 - AWS Lambda 를 통한 hellow, world 실행 - Lambda 설명 1. 실습 1) AWS 콘솔에서 lambda 검색 2) 함수 생성 클릭 3) 함수 생성 - 블루 프린트 - hellow-world-python 검색 - 선택 이후 구성 클릭 4) 기본 정보 작성 - 함수 이름 작성 - AWS 정책 템플릿에서 새 역할 생성 - 역할 이름 지정 5) 함수 생성 클릭 6) 우상단의 드롭다운 버튼에서 테스트 이벤트 구성 클릭 7) 이벤트 이름 작성 및 생성 - 본문 내용 수정 8) 테스트 클릭 9) 테스트 결과 - 로그 클릭시 출력 결과 등을 볼 수 있음 - 세부 정보 클릭시에 작업 시간, 로그 출력 등을 볼 수 있음..

[빅데이터] MacOS 에 hadoop 설치

[빅데이터] MacOS 에 hadoop 설치

* 단순 설치 및 명령어만 실험을 하였기에 제대로 된 설치법(sh 수정 등)은 다른 블로그를 참고 바랍니다. 0. 목표 - macOS에 hadoop 설치 1. 실습 1) hadoop 설치 brew install hadoop - 결과 - hadoop 위치 : /usr/local/Cellar/hadoop/3.3.0 2) 네임 노드 포맷 hdfs namenode -format - 결과 3) 대쉬보드 확인 - http://localhost:8088 - 노드 설정 등을 아무것도 하지 않은 상태 4) hadoop 명령어 테스트 - 명령어 참고 : blog.voidmainvoid.net/175 hdfs dfs -ls 2. 참고 - 맥(mac)에서 하둡(hadoop) 설치하기 - Hdfs dfs 명령어 정리 및 설명(..

[GA] 세션 vs 유저

[GA] 세션 vs 유저

0. 목표 - GA 에서 세션과 유저의 차이 1. 세션 1) 시간 기반 완료 - 방문자 활동이 없을 경우 30분 후(세션 설정을 통해 시간 변경 가능) - 자정(보기의 시간대 설정으로 기준 변경 가능) 2) 캠페인 변경 - 어떤 캠페인을 통해 방문한 뒤 떠났다가, 다른 캠페인을 통해 다시 방문한 경우 2. 유저 1) 새로운 기기나 브라우저로 접근할 때 새로운 유저로 잡힘. 2) 쿠키를 지우면 새로운 유저로 잡힘. 3. 참고 - Users vs. Sessions: What’s the difference? - 애널리틱스에서 웹 세션을 정의하는 방법

[AWS] EC2 인스턴스 생성

[AWS] EC2 인스턴스 생성

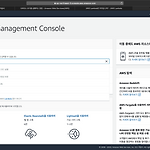

0. 목표 - AWS EC2 인스턴스 생성 1. 실습 1) 로그인 - 우측 위 메뉴에서 리전 선택(서울) 2) EC2 검색 3) 좌측 메뉴에서 인스턴스 -> 우상단 인스턴스 시작 4) 원하는 인스턴스 유형 선택 - 여기서는 첫 번째 유형 선택 5) 프리 티어 표시 되어 있는 것 선택 6) 상단의 탭을 눌러 원하는대로 수정 - 여기서는 태그 추가 실행 7) 검토 탭을 눌러 내용 확인 이후 시작하기 클릭 8) 키 페어 생성 - 키 페어 다운로드 이후 인스턴스 시작 - 보안 주의 9) 인스턴스 보기 클릭 10) 확인 2. 참고 - 서비스 운영이 쉬워지는 AWS 인프라 구축 가이드(김담형)

[AWS] AWS MFA 활성화하기

[AWS] AWS MFA 활성화하기

0. 목표 - AWS 계정 MFA 활성화하기 1. 회원가입 1) 이메일 정보 - 링크 2) 개인정보 - 개인으로 생성 * 전화번호 잘 써야됨. 3) 전화번호 인증 4) 코드입력 5) 무료 6) 로그인 2. 실습하기 1) 루트 로그인을 통한 콘솔 접속 2) 검색 창에 iam 검색 3) 두번째 메뉴인 루트 계정에서 MFA 활성화 클릭 4) MFA 관리 클릭 5) 멀티 팩터 인증(MFA) -> MFA 활성화 클릭 6) 가상 MFA 디바이스 클릭 이후 계속 - 크롬으로 하면 세개 메뉴 다 활성화 됨 6) 가운데의 QR 코드 표시를 눌러 바코드를 표출한 뒤 아래의 호환 앱을 통해 연속된 코드 확인 및 MFA 할당 클릭 - 구글 OTP로 진행 * 호환 앱 7) 완료 8) 좌측 대시보드 버튼 클릭 및 확인 3. 결과..

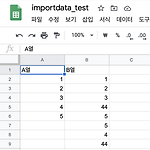

[자동화] importrange를 통한 스프레드시트 내용 복사

[자동화] importrange를 통한 스프레드시트 내용 복사

0. 목표 - google spreadsheet의 importrange 함수를 통한 스프레드시트 내용의 복사 1. 함수 사용 방법 - 메뉴얼 - IMPORTRANGE("시트주소", "범위") * importdata 함수의 경우 한 스프레드시트에서 최대 50개의 importdata 함수를 호출할 수 있었다고 하나, 새로운 버전에서는 한도가 삭제되었다고 함 2. 실습 1) 실습 데이터 생성 2) 새로운 시트 생성 - A1셀에 함수 적용 =importrange("https://docs.google.com/spreadsheets/d/시트url", "시트1!A:B") - 결과 * 주의사항 - 해당범위내에 문자 입력시 에러 발생 3. 참고 - 공식 메뉴얼

[GA] Google Optimize 를 이용한 A/B Test

[GA] Google Optimize 를 이용한 A/B Test

0. 목표 - google optimize를 이용한 a/b test 1. 실습 1) 링크 접속 - 계정 만들기 클릭이후 내용 작성 - 내용 작성 2) 컨테이너 생성 3) 생성된 컨테이너 클릭 - 환경 만들기 클릭 4) 내용 작성 - 테스트 명, url, A/B 테스트 선택 5) 생성된 테스트 선택 6) 대안 추가 7) 수정 클릭 8) 각 대안 페이지 마다 내용 수정 9) 대상 페이지 설정 10) Google Analytics 연결 11) 목표 설정 12) 최적화 도구 설치1 - 안내 보기 클릭 13) 최적화 도구 설치2 - 스니펫을 대상 페이지의 태그 아래에 삽입 - Chrome 확장 프로그램 설치 - 삽입 결과 14) 시계 그림 눌러 시간 설정 15) 시작 * 주의사항 : 한번 시작한 테스트를 종료하였..