| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 텐서플로

- 서평

- Python

- 리눅스

- Google Analytics

- MATLAB

- Linux

- 시각화

- MySQL

- SQL

- 한빛미디어

- Ga

- 파이썬

- 블로그

- Blog

- 파이썬 시각화

- 딥러닝

- 서평단

- tensorflow

- Tistory

- 한빛미디어서평단

- 티스토리

- 월간결산

- Visualization

- 매틀랩

- 통계학

- 독후감

- matplotlib

- Pandas

- python visualization

- Today

- Total

목록sklearn (5)

pbj0812의 코딩 일기

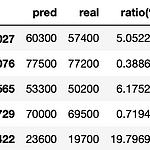

[Machine Learning] RandomForest 를 이용한 집값 예측

[Machine Learning] RandomForest 를 이용한 집값 예측

0. 목표 - RandomForest 를 이용한 집값 예측 1. 실습 1) 데이터 생성 - randomGenerator : 데이터 길이, 최소값, 최대값을 입력하면 주어진 길이만큼 최소값, 최대값 범위에서 랜덤한 정수로 채워줌 - root, yard, bathroom, livingroom, room 변수 생성 - price에는 각 변수에 원하는 값을 매겨서 합산(정확한 가중치 적용) import pandas as pd import random def randomGenerator(num_len, num_min, num_max): result = [] for i in range(num_len): result.append(random.randint(num_min, num_max)) return result r..

[kaggle] Intermediate Machine Learning 수료 과정

[kaggle] Intermediate Machine Learning 수료 과정

0. 목차 및 내용 1) Introduction - 이전 과정(Intro to Machine Learning) 에 대한 복습 및 앞으로의 과정 소개 2) Missing Values - 결측값에 관한 처리 방안(sklearn.impute 의 SimpleImputer 소개) (1) 칼럼 삭제 (2) 다른 숫자로 채우기 (3) 라벨링? 을 통한 표기 3) Categorical Variables - 카테고리 항목에 대한 라벨링 방안 및 학습 과정 소개(sklearn.preprocessing 의 LabelEncoder, OneHotEncoder 소개) (1) 칼럼 삭제 (2) 다른 숫자로 라벨링 (3) 원-핫 인코딩 4) Pipelines - 데이터 전처리부터 모델구성까지 도와주는 pipeline 에 대한 소개 ..

[통계학] PYTHON 을 통한 AUPRC 구현 및 sklearn 과 비교

[통계학] PYTHON 을 통한 AUPRC 구현 및 sklearn 과 비교

0. 목표 - PYTHON 을 통한 AUPRC 구현 및 sklearn 과 비교 1. 스크래치 실습 1) library 호출 import pandas as pd import matplotlib.pyplot as plt 2) 데이터 생성 index = [i for i in range(1, 21)] label = ['p', 'p', 'n', 'p', 'p', 'p', 'n', 'n', 'p', 'n', 'p', 'n', 'p', 'n', 'n', 'n', 'p', 'n', 'p', 'n'] probability = [0.9, 0.8, 0.7, 0.6, 0.55, 0.54, 0.53, 0.52, 0.51, 0.505, 0.4, 0.39, 0.38, 0.37, 0.36, 0.35, 0.34, 0.33, 0.3, ..

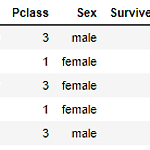

[Python] sklearn의 DecisionTree 사용 / Graphviz 설치

[Python] sklearn의 DecisionTree 사용 / Graphviz 설치

0. 목표 - sklearn 의 DecisionTree를 이용한 Titanic 문제 해결 1. DecisionTreeClassifier(참고) 1) criterion : 분류 기준(default = 'gini') 2) max_depth : decision tree의 깊이 지정 3) min_samples_split : 최소 샘플 개수 4) min_samples_leaf : 최소 분류 수 5) max_features : 최대 피쳐 수 2. 데이터셋 준비 - kaggle 타이타닉 데이터 셋 다운로드(링크에서 titanic 검색) 3. 코드 작성 1) 데이터 선정 import pandas as pd data = pd.read_csv('E:/수료증/인프런/밑바닥부터시작하는머신러닝/train.csv') data2 ..

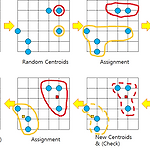

[통계] k-means 설명 / 코드 분석

[통계] k-means 설명 / 코드 분석

1. 정의 k-평균 알고리즘(K-means algorithm)은 주어진 데이터를 k개의 클러스터로 묶는 알고리즘으로, 각 클러스터와 거리 차이의 분산을 최소화하는 방식으로 동작한다. 이 알고리즘은 자율 학습의 일종으로, 레이블이 달려 있지 않은 입력 데이터에 레이블을 달아주는 역할을 수행한다. 이 알고리즘은 EM 알고리즘을 이용한 클러스터링과 비슷한 구조를 가지고 있다. 2. 절차 1) 초기 (군집의) 중심으로 k개의 객체를 임의로 선택한다. 2) 각 자료를 가장 가까운 군집 중심에 할당한다. 3) 각 군집 내의 자료들의 평균을 계산하여 군집의 중심을 갱신(update)한다. 4) 군집 중심의 변화가 거의 없을 때(또는 최대 반복수)까지 2) 와 3) 을 반복한다. * 군집의 수(k)는 미리 정해 주어야..