| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- 한빛미디어

- SQL

- tensorflow

- Visualization

- 통계학

- Python

- Pandas

- 파이썬

- 리눅스

- 서평단

- 매틀랩

- 독후감

- Google Analytics

- 한빛미디어서평단

- MATLAB

- 딥러닝

- 파이썬 시각화

- 블로그

- 텐서플로

- 월간결산

- Linux

- Tistory

- 서평

- MySQL

- 시각화

- Blog

- python visualization

- matplotlib

- 티스토리

- Ga

- Today

- Total

목록분류 전체보기 (596)

pbj0812의 코딩 일기

[빅데이터기술] Docker 이미지 파일 생성

[빅데이터기술] Docker 이미지 파일 생성

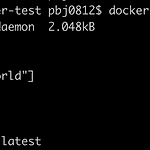

0. 목표 - Docker 이미지 파일 생성 1. 실습 1) Dockerfile 생성 - 파일명 Dockerfile - alpine 이미지 사용 - 결과 : hello world 출력 FROM alpine CMD ["echo", "hello world"] 2) 빌드 - 현재 폴더에서 Dockerfile 을 찾아 빌드하고 이름은 pbj0812/test 로 지정, latest 는 버전 docker build ./ -t pbj0812/test:latest 3) 생성 이미지 확인 - 두 개 있는 이유는 그냥 하나 더 만들은거... docker images 4) 컨테이너 실행 docker run -it pbj0812/test 2. 참고 - 따라하며 배우는 도커와 CI환경

0. 목표 - arrow 라이브러리 소개 1. 실습하기 1) 설치 pip install -U arrow 2) library 호출 import arrow 3) arrow 형태 객체 얻기 a = arrow.get('2013-05-11T21:23:58.970460+07:00') print(a) print(type(a)) - 결과 2013-05-11T21:23:58.970460+07:00 4) 지금시간 얻기(UTC 기준) utc = arrow.utcnow() print(utc) - 결과 2020-12-06T14:25:21.215593+00:00 5) 시간 조정하기 utc2 = utc.shift(hours=-1) print(utc2) - 결과 2020-12-06T13:29:06.976277+00:00 6) 타임존..

[자동화] airflow 에 airflow-code-editor 설치

[자동화] airflow 에 airflow-code-editor 설치

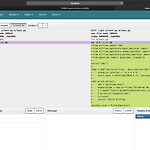

0. 목표 - airflow 에 airflow-code-editor plugin 설치 1. 설치 1) airflow 설치 pip install apache-airflow 2) airflow-code-editor 설치 pip install airflow-code-editor 3) 이외 라이브러리들 - 되는 버전을 알려주신 빅데이터 엔지니어 한용준 님께 감사의 인사를 드립니다. pip install marshmallow==2.19.5 pip install marshmallow-enum==1.5.1 pip install marshmallow-sqlalchemy==0.18.0 2. airflow 실행 1) 실행 airflow initdb airflow webserver -p 8080 2) 익스플로어에 local..

[AWS] AWS DynamoDB 테이블 생성 및 삭제

[AWS] AWS DynamoDB 테이블 생성 및 삭제

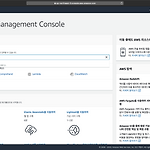

- 해당 튜토리얼은 AWS 에서 제공하는 튜토리얼을 참고하였습니다. 0. 목표 - AWS 의 DynamoDB 테이블 생성 및 삭제 1. 실습 - AWS console 에서 dynamodb 검색 2) 테이블 만들기 클릭 3) 테이블 설정 이후 하단의 생성 클릭 - 테이블 이름 작성 - 기본 키 작성 - 기본 설정 사용 체크 해제 4) 항목 만들기 클릭 5) 내용 작성 및 저장 6) 데이터 추가 결과 - 5번 넣음 7) 스캔 -> 쿼리 8) 검색 내용 작성 이후 검색 시작 클릭 9) 데이터 삭제 - 데이터 옆의 체크 박스 클릭 -> 작업 -> 삭제 10) 테이블 삭제 - 테이블 명 클릭 -> 테이블 삭제 클릭 2. 참고 - NoSQL 테이블 생성 및 쿼리

[AWS] Amazon Comprehend 를 이용한 감정분석

[AWS] Amazon Comprehend 를 이용한 감정분석

0. 목표 - Amazon Comprehend 를 이용한 감정분석 1. 실습 1) AWS Console 에서 Amazon Comprehend 검색 2) Launch Amazon Comprehend 클릭 3) 예제 문장 입력 및 Analyze 클릭 - 부정적인 글을 입력 4) Sentiment 클릭 - NEGATIVE 가 0.9 이상으로 나옴

[AWS] Lambda 를 통한 hellow, world 실행

[AWS] Lambda 를 통한 hellow, world 실행

- 공식 튜토리얼을 참조하시면 더욱 많은 예제를 보실 수 있습니다. 0. 목표 - AWS Lambda 를 통한 hellow, world 실행 - Lambda 설명 1. 실습 1) AWS 콘솔에서 lambda 검색 2) 함수 생성 클릭 3) 함수 생성 - 블루 프린트 - hellow-world-python 검색 - 선택 이후 구성 클릭 4) 기본 정보 작성 - 함수 이름 작성 - AWS 정책 템플릿에서 새 역할 생성 - 역할 이름 지정 5) 함수 생성 클릭 6) 우상단의 드롭다운 버튼에서 테스트 이벤트 구성 클릭 7) 이벤트 이름 작성 및 생성 - 본문 내용 수정 8) 테스트 클릭 9) 테스트 결과 - 로그 클릭시 출력 결과 등을 볼 수 있음 - 세부 정보 클릭시에 작업 시간, 로그 출력 등을 볼 수 있음..

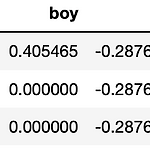

[수학] PYTHON 을 이용한 TF-IDF 구현

[수학] PYTHON 을 이용한 TF-IDF 구현

0. 목표 - PYTHON 을 이용한 TF-IDF 구현 1. 실습 1) library 호출 import pandas as pd from math import log 2) 데이터 생성 doc1 = 'I am a boy' doc2 = 'I am a girl' doc3 = 'I am a a a man' 3) TF-IDF 구현 모듈 - DF 를 먼저 구하여 이후 TF-IDF 를 구할 때 값을 이용해 줌. def doc(*args): doc_list = [] tf = pd.DataFrame() idf = pd.DataFrame() tf_idf = pd.DataFrame() # 단어 리스트 생성 for i in args: # 단어 분해 tmp_list = i.split(' ') # 리스트 결합 doc_list +=..

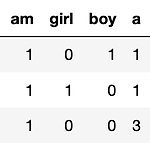

[수학] PYTHON 을 이용한 문서 단어 행렬(DTM) 구현

[수학] PYTHON 을 이용한 문서 단어 행렬(DTM) 구현

0. 목표 - PYTHON 을 이용한 문서 단어 행렬(Document-Term Matrix, DTM ) 구현 1. 실습 1) library 호출 import pandas as pd 2) DTM 계산 모듈 구현 - *args 를 이용하여 여러개의 데이터를 인풋으로 받을 수 있게 설계 def doc(*args): doc_list = [] df = pd.DataFrame() for i in args: # 단어 분해 tmp_list = i.split(' ') # 리스트 결합 doc_list += tmp_list doc_list = list(set(doc_list)) for i in doc_list: tmp = [] for j in args: # 단어 분해 tmp_list = j.split(' ') # 단어 세기..

[PYTHON] 남은 업무시간 계산하기

[PYTHON] 남은 업무시간 계산하기

0. 목표 - python 을 이용하여 남은 업무시간 계산하기 1. 실습 1) library 호출 import pandas as pd 2) 기본 메타정보 입력 - 마지막으로 퇴근한 요일 - 일주일간 채워야 하는 근무시간 - 제외시간(점심시간) print('마지막으로 퇴근한 요일을 입력하세요.') print('1부터 7까지의 숫자로 입력하세요(1 : 월요일 ~ 7 : 일요일)') end_day = int(input()) print('일주일간 채워야 하는 시간을 입력하세요(자연수)') total_time = int(input()) print('제외시간을 입력해 주세요(자연수)') except_time = int(input()) - 결과 마지막으로 퇴근한 요일을 입력하세요. 1부터 7까지의 숫자로 입력하세요(..

[빅데이터] MacOS 에 hadoop 설치

[빅데이터] MacOS 에 hadoop 설치

* 단순 설치 및 명령어만 실험을 하였기에 제대로 된 설치법(sh 수정 등)은 다른 블로그를 참고 바랍니다. 0. 목표 - macOS에 hadoop 설치 1. 실습 1) hadoop 설치 brew install hadoop - 결과 - hadoop 위치 : /usr/local/Cellar/hadoop/3.3.0 2) 네임 노드 포맷 hdfs namenode -format - 결과 3) 대쉬보드 확인 - http://localhost:8088 - 노드 설정 등을 아무것도 하지 않은 상태 4) hadoop 명령어 테스트 - 명령어 참고 : blog.voidmainvoid.net/175 hdfs dfs -ls 2. 참고 - 맥(mac)에서 하둡(hadoop) 설치하기 - Hdfs dfs 명령어 정리 및 설명(..